Нейросети все чаще становятся оружием в руках преступников — с их помощью обманывают людей, крадут деньги корпораций и банков. Несколько лет назад студент петербургского университета ИТМО Виталий Роговой начал работать над технологией разоблачения дипфейков. В 2023 году он превратил свою разработку в стартап, получил грант и уже в этом году планирует выпустить коммерческое приложение, которое будет защищать от мошенников, использующих нейросети для своих преступлений. Как именно он и его команда разоблачают дипфейки, где уже сейчас можно протестировать технологию и могут ли дипфейки стать настолько совершенными, что разоблачить их уже не удастся? На все эти вопросы Виталий ответил в беседе с «Собака.ru».

Чем именно занимается ваша команда?

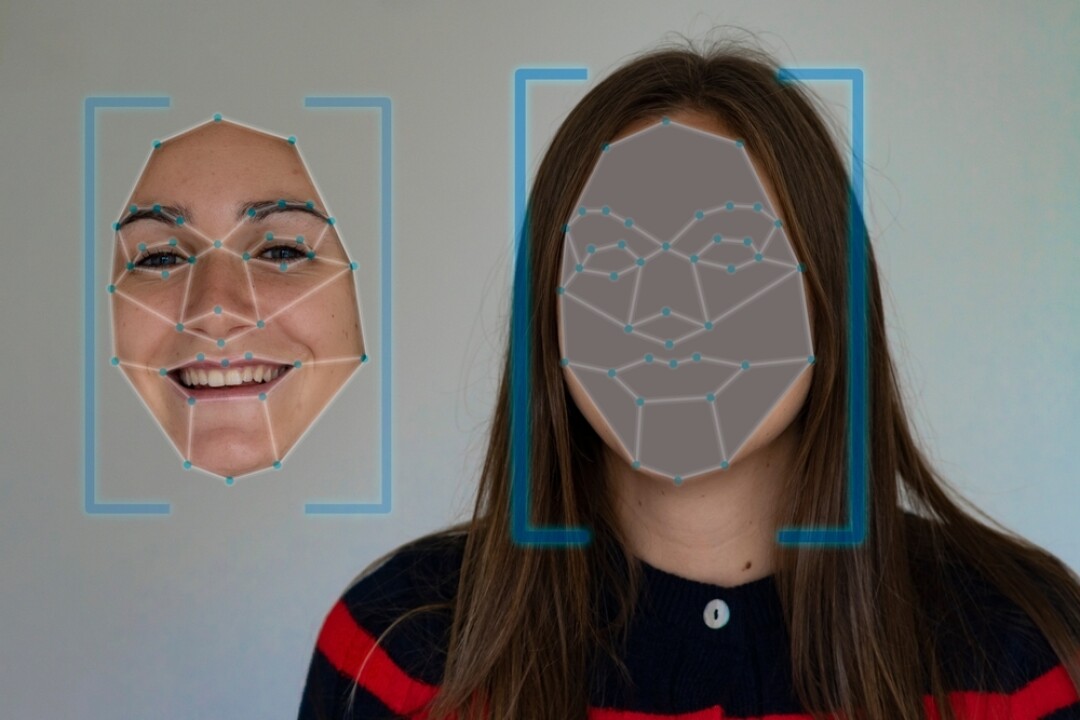

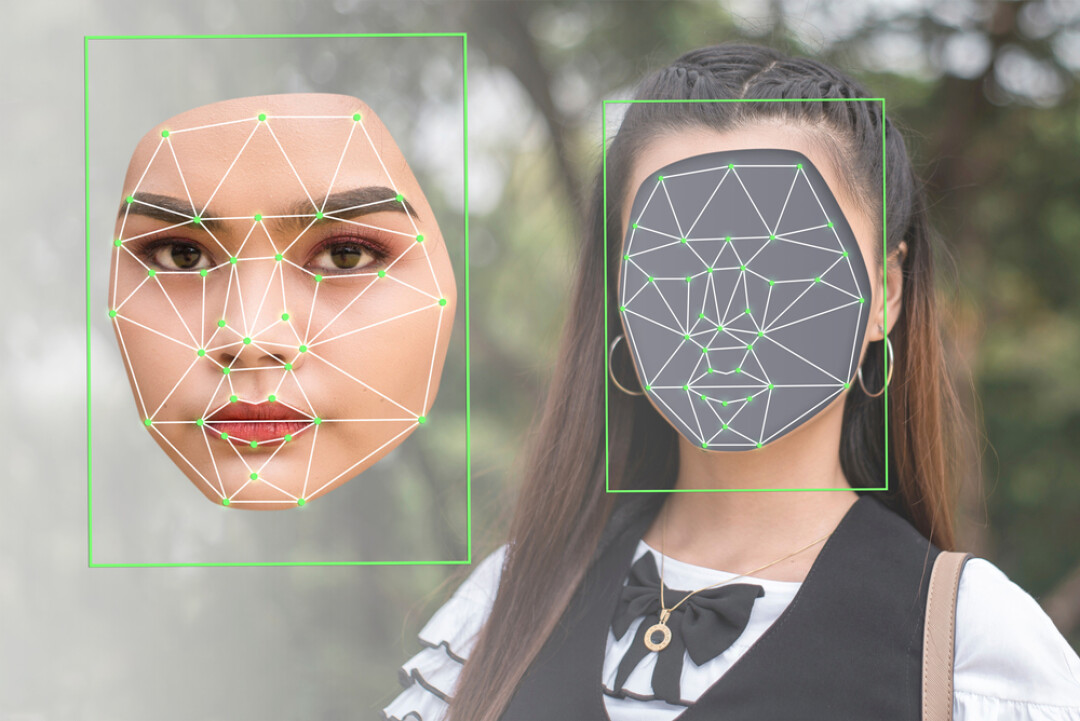

Мы создаем систему, которая сможет распознавать сгенерированные и измененные с помощью нейросетей фотографии, видео или записи голоса. То есть это может быть как генерация с нуля, так и изменение лица или голоса с помощью нейросетей.

Почему вы решили заняться этой темой?

Потому что проблема дипфейков становится все острее — все чаще можно увидеть в новостях заголовки, что с их помощью совершаются целевые атаки на бизнес или отдельных людей. Самый громкий случай из недавних — когда мошенники украли у международной корпорации 25 млн долларов, обманув с помощью дипфейка сотрудника ее гонконгского офиса.

Еще один громкий скандал — фейковые обнаженные фотографии Тейлор Свифт, которые разместили в сети в январе этого года.

Все это подрывает доверие в обществе: доверие к СМИ, к бизнес-партнерам, к финансовым институтам, к технологиям к людям в целом. Как можно на 100% доверять чему-то, если не знаешь, что за контент ты сейчас видишь — реальный или сгенерированный?

А насколько сейчас распространено мошенничество с помощью нейросетей? Это эксклюзивные преступления, нацеленные на богатых жертв? Или вскоре знакомые всем «операторы Сбербанка» заговорят с нами голосами друзей и родственников?

В настоящее время это в основном целевые атаки. Для их проведения требуется не только собрать образцы голоса, но и изучить поведение жертвы, а также стиль его общения с друзьями и коллегами, чтобы все выглядело правдоподобно.

Но на самом деле используемая в подобных аферах технология не такая сложная, поэтому, скорее всего, да… скоро она выйдет на массовый сегмент. Я думаю, что это дело пары лет, ведь сегодня собрать биометрию (к примеру, образцы голоса или фотографии) не составит больших проблем.

Из чего родился ваш проект?

Собственно, первоначально это была идея для моей дипломной работы, потом я подумал: зачем исследовать и писать диплом просто так, если его можно превратить в сервис?

Плотно этим мы занялись где-то год назад. Знаете, как это бывает — сидите на кухне с друзьями и думаете: а что если попробовать что-то такое провернуть. Мы попробовали, выиграли на внутриуниверситетском конкурсе в ИТМО грант в 1 млн рублей и на эти деньги собрали команду — это был уже конец 2023 года.

Сейчас у нас есть сотрудники, которые занимаются бэкенд- и фронтенд-разработкой, инженеры по машинному обучению — большая часть из них студенты ИТМО, но есть и сторонние специалисты.

За последние месяцы мы «пропылесосили» все российские конкурсы и профессиональные конференции. Собрали награды (к примеру, попали в ТОП-5 лучших проектов международной университетской премии «Гравитация - 2024» ), но самое главное, искали контакты, чтобы организовать коллаборацию, общались с потенциальными потребителями, пытались понять, что интереснее всего потребителям: анализ голоса, изображения, видео.

А как именно работает ваша технология?

Мы анализируем структуру контента, выявляя шумы и различные спектральные отклонения. Современные нейросети по своей природе довольно дискретны, поэтому при создании контента они оставляют определённые следы, которые можно обнаружить.

Вы имеете в виду, что изображение все равно будет немного неестественным?

Нет-нет, дело не в этом. Речь идет о том, как взаимодействуют между собой отдельные пиксели или звуковые сигналы. Это взаимодействие не такое плавное, как на естественном изображении, даже если это незаметно для глаза.

Причем большинство генеративных моделей сейчас имеют сходную архитектуру, а следовательно, и сходные следы. Просто у какой-то нейросети они выражены сильнее, а у какой-то слабее.

При этом вы тоже используете для поиска фейка нейросети?

Да, в том числе и их. Однако основную ставку мы делаем на первичную обработку изображения не нейросетевыми алгоритмами. А вот какими — это уже наш секрет.

Насколько успешен этот метод?

На исследовательских данных у нас достаточно хорошие показатели — более 95% верных ответов. Но в реальной жизни результат пока ниже, поэтому мы активно дорабатываем наш алгоритм, чтобы он лучше работал в естественных условиях.

Проблема усугубляется тем, что существует множество способов обработки изображений. Например, как реальную фотографию, так и фейк можно отретушировать в фотошопе или пропустить через другую модель, которая улучшает качество фотографий. Любое вмешательство создает дополнительные сложности для обнаружения подделок.

Ваш алгоритм справляется лучше, чем человек?

Да, мы проводили несколько тестов на конференциях — предлагали зрителям 17 пар изображений (одно сгенерированное и одно настоящее). Лучший результат у человека — 13 угадываний. Нейросеть пока дает 16 из 17, мы работаем над тем, чтобы улучшить результат.

Насколько сейчас можно говорить, что этот продукт готов?

Сейчас мы запустили альфа-тест модели в качестве бесплатного telegram-бота. Там любой желающий может проверить качество работы нашего алгоритма и, при желании, помочь его дообучить.

Вы можете загружать, скажем, изображения, смотреть результат анализа и писать — справилась ли модель с задачей или нет. В ходе такого использования она будет постоянно дообучаться.

Каким будет финальный продукт?

Наше решение будет иметь два направления. С одной стороны, мы разрабатываем систему для бизнеса, которую можно будет интегрировать в контуры безопасности, например банка. Эта система будет способна анализировать звонки и конференции, например в Zoom, чтобы выявлять дипфейки.

С другой стороны, мы планируем предложить B2C решение, чтобы широкий круг пользователей также мог им воспользоваться.

В целом мы надеемся вывести продукт на рынок в этом или следующем квартале.

В завершение еще один вопрос. А можем ли мы прийти к ситуации, когда дипфеки станут настолько совершенными, что никакой алгоритм — ни ваш, ни каких-то из ваших конкурентов — не сможет их обнаружить?

Я думаю, что мы, каков бы ни был уровень технологий, с ним справимся, и потенциальная проблема будет решена. Не с помощью нашего алгоритма, так с помощью других мер, к примеру, обязательного маркирования всего контента, который генерируется нейросетями с помощью невидимого водяного знака.

Комментарии (0)